Zwar haben sich die massiven Beeinträchtigungen des Alltags merklich reduziert, die individuellen und gesellschaftlichen Belastungen in Folge der Corona-Pandemie sind aber noch immer spürbar. Das Post-Covid-Syndrom ist mittlerweile als Krankheitsbild anerkannt, und die Verbesserung von Diagnose, Prophylaxe und Therapie bilden eine Triebfeder medizinischer Forschung. Professor Thomas Urban entwickelte zusammen mit dem Post-Covid-Zentrum in Senftenberg ein spezifisches Therapie-Konzept für Post-Covid-19-Patient:Innen und stellte in einem Bericht zu seinem zurückliegenden Forschungssemester seine Ansätze, Vorgehensweise und einige Ergebnisse vor, wobei dies auch zentrale Themen seiner zweiten Habilitationsschrift sind.

Die angewandte Wissenschaft im medizinischen Bereich hatte sich bereits zu Anfang der Pandemie durch eine immens schnelle Entwicklung und Bereitstellung verschiedener wirksamer Impfstoffe und deren kontinuierliche Anpassung an unterschiedliche Varianten hervorgetan. Ohne diese Errungenschaften der pharmazeutischen Einrichtungen und Unternehmen in Forschung und Produktion wären die Folgewirkungen von Corona gewiss weit drastischer und langwieriger gewesen. Die Reaktion auf die Pandemie macht das innovative Potential anwendungsnaher, medizinischer Forschung sowie der Health Tech deutlich, die modernste Technologien mit einem Fokus auf das physische und psychische Wohl von Patient:Innen verbindet.

Forschung in Progress

Die Forschung in diesem Bereich ist aber keineswegs abgeschlossen: Einerseits gibt es immer neue Varianten des Virus und damit die Notwendigkeit, die Impfstoffe anzupassen, um vulnerable Gruppen weiter effektiv zu schützen. Andererseits muss sich die medizinische Entwicklung mit den physischen und psychischen Auswirkungen der Pandemie befassen. Wie bei der Entwicklung von Impfstoffen stellt dabei die Neuartigkeit des Erregers die Forschung vor Herausforderungen, muss es doch zunächst darum gehen, das Krankheitsbild selbst zu verstehen und seine verschiedenartigen Ausprägungen zu charakterisieren. An diese Grundlegung können dann Überlegungen zu therapeutischen Maßnahmen anschließen.

Dem Post-Covid-Syndrom kommt als nunmehr anerkanntem Krankheitsbild breite gesellschaftliche Aufmerksamkeit zu, gerade weil die Spätfolgen einer Corona-Erkrankung nicht wenige Menschen betreffen und in ihrem Alltag belasten. Auch wenn die beiden Phänomene umgangssprachlich synonym verwandt werden, bezeichnet Long-Covid die anhaltenden Beeinträchtigungen mehr als vier Wochen bis zu drei Monaten nach der Infektion, und Post-Covid den anschließenden Zeitraum.[1]

Vergleichbar mit anderen Infektionskrankheiten können aus einer Corona-Infektion (SARS-CoV-2) verschiedenartige Langzeitfolgen resultieren, die Beeinträchtigungen der Organsysteme wie Herz, Lunge, Gehirn und u.a. Nebenorgane über einen längeren Zeitraum umfassen. Langzeit meint hier anhaltenden Beschwerden zwölf Wochen nach der eigentlichen Infektion, wobei die Häufigkeit des Auftretens zwischen 10% und 20% schwankt. Als verursachende Faktoren werden aktuell eine Überaktivierung des Immunsystems und eine Thrombusbildung im Mikrogefäßsystem diskutiert.[2] Die Folgen für die Menschen sind wiederum breitgefächert und reichen von Erschöpfungszuständen (Fatigue[3]) über Herz-/Kreislaufprobleme und Gleichgewichtsstörungen bis hin zu Nervenleiden und anhaltendem Schmerz. Diese Varianz legt die Komplexität des Syndroms nahe, was einerseits seine medizinische Beschreibung sowie ursächliche Verortung und andererseits die therapeutischen Ansätze anbetrifft, wobei hier verschiedene Disziplinen der Medizin kooperieren müssen. Das Ziel der Therapie ist neben der Symptomlinderung die Vermeidung der Verstetigung der Leiden und Befähigung der Betroffenen zur Teilhabe am Privat- und Berufsleben.

Der Blended-Therapy-Ansatz

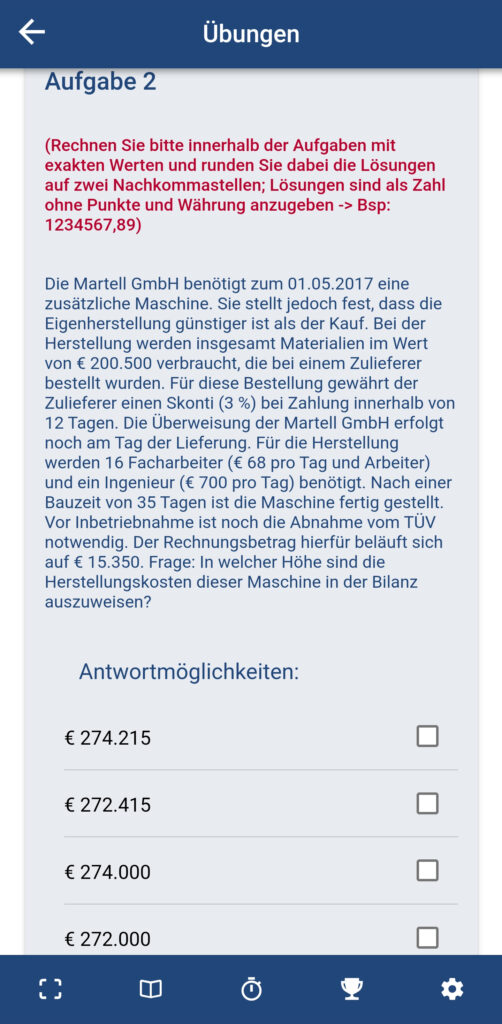

Für diese Multidisziplinarität eignet sich ein innovativer Therapieansatz, den Professor Urban im Rahmen seines Forschungssemester analysierte und den er zugleich an einem Corona-Therapie-Zentrum empirisch untersuchen konnte. Der gewählte Zugang nennt sich Blended-Therapy und verschränkt klassisch-analoge mit digitalen Therapieformen. Durch die digitale Ergänzung wird eine flexiblere, räumlich wie zeitlich ungebundenere Behandlung möglich, die auch kontinuierliche therapeutische Formen und eine individuelle Umsetzung ärztlicher Empfehlungen zulässt. Zum Beispiel erlauben mobile Apps und Smart-Watches eine automatisierte, engmaschige (Selbst-)Kontrolle sowie spezielle Monitor-Kamera-Systeme überwachte Übungen in der Häuslichkeit und deren Kontrolle in Echtzeit. Die Forschung an diesen Therapieansätzen ist auch deswegen geboten, weil es derzeit kaum spezifische sektorübergreifende Konzepte gibt und bislang auch kein Therapieansatz bei Post-Covid als Standard empfohlen wird, der sich den Ursachen der Leiden im Unterschied zu symptomlinderungsorientierten Ansätzen annimmt und der nach empirischen Kriterien überprüft worden wäre.

Orientiert an den S2k-Leitlinie der Deutschen Gesellschaft für Neurologie und dem Post-COVID-Versorgungskonzept der LMU wurde eine Therapie entwickelt, die die spezifischen Bedarfe von Post-Covid-Betroffenen einerseits berücksichtigt, aber andererseits den Patient:Innen in gewissem Maße Belastungen zumutet. Diese waren in den bisherigen Post-Corona-Therapien eher unüblich.[4] Eine Folge des beeinträchtigten Energiehaushalts sind mögliche spontane Zusammenbrüche (postexertionelle Malaise), die Patient:Innen nicht voraussehen konnten und die den Rekonvaleszenzprozess immens zurückwarfen.[5] Zugleich haben Therapiemethoden, die Formen der Belastung nutzen und Überanstrengungen durch kontrollierte Bedingungen vermeiden, durchaus Erfolge vorzuweisen. Das individuelle Energiemanagement und die Minimierung von Überlastung waren in den Therapieansätzen wichtige Faktoren.

Die Blended-Therapy verknüpft die klassische Behandlung in Präsenz mit digitalen Interventionsinstrumenten, womit sich die Möglichkeit zur Echtzeitanalyse der Belastung, des Leistungsvermögens und der Beanspruchung des energetischen Haushalts der Patient:Innen während der Übungen (auch in der Häuslichkeit) bietet. Anstatt einer umfassenden Schonung wurden sensomotorische Einschränkungen und Fatigue mit einem Gleichgewichtstraining und motorischen Übungstherapien begegnet. Anschließend wurde eine auf Fatigue ausgelegte kognitive Verhaltenstherapie umgesetzt, in deren Fokus zudem die sekundären psychosomatischen Symptome sowie die Erfassung der subjektiven Wirksamkeit der Trainingstherapie standen.

Studie und Auswertung

Die begleitende Studie fand in einem dreijährigen Zeitraum am dem Corona-Therapie-Zentrum Lausitz (Senftenberg) statt. Neben den Veränderungen der Leitsymptome mussten auch allgemeine Auswirkungen auf die physische und psychische Gesundheit sowie sekundäre Effekte beachtet werden. Der Studie standen 407 Patient:Innen zur Verfügung, die bestimmte Kriterien erfüllten. Die Trainings fanden in Präsenz ebenso statt wie bei den Patient:Innen zu Hause, wobei so die erforderliche Übungsdichte erreicht werden konnte. Die zweite Phase wurde von einer Befragungsstudie begleitet, um hieraus wichtige Erkenntnisse über den Nutzen therapeutischer Maßnahmen im Rahmen der Gesundheitsversorgung zu gewinnen.

Die Evaluation der Therapie bemaß sich an zwei Kriterien, den Post-Covid-Leitsymptomen und den motorischen Fatigability-Parametern, wobei letztere einen Indikator für die Beweglichkeit bereitstellen. Generell ließen sich positive Effekte sowohl in Hinsicht der Leitsymptome als auch der motorischen und kognitiven Fatigability-Parameter ausmachen.[6] Am Ende konnten also ebenso positive therapeutische Effekte festgehalten werden sowie der Nutzen des Blended-Therapy-Ansatzes, der sich zudem in das bestehende Versorgungssystem integrieren lässt. Die Therapie machte es den Betroffenen nicht zuletzt möglich, mit ihrem verringerten Energiehaushalt umgehen zu lernen, und zugleich die verbliebenen Kapazitäten effektiv zu nutzen. Um den Patient:Innen wieder die Chance zur aktiven Teilhabe am gesellschaftlichen oder beruflichen Leben zu bieten, ist dies ein erster, wichtiger Schritt.

Die Habilitationsschrift mit dem Titel „, Sektorenübergreifende beanspruchungsgesteuerte multimodale Blended Therapy für Post-COVID-19-Patienten mit Fatigue und sensomotorischer Instabilität“ hat Professor Urban im Bereich Versorgungswissenschaft des Instituts für Medizintechnologie an der Brandenburgischen Technischen Universität Cottbus-Senftenberg eingereicht.

[1] Vgl. Urban 2025, Sektorenübergreifende beanspruchungsgesteuerte multimodale Blended Therapy für Post-COVID-19-Patienten mit Fatigue und sensomotorischer Instabilität, S. 10 – 24, (Manuskript) und https://www.kvberlin.de/fuer-praxen/aktuelles/themen/thema/long-covid.

[2] Vgl. Urban, Thomas et al., Fatigue und sensomotorische Instabilität. Neurologisch kontrollierte Konversion von Post-COVID-19-Patienten, in: Nervenarzt (2024:95, S. 1104 – 1115), S. 1107

[3] „Die Fatigue wird durch eine subjektiv oft stark einschränkende, zu den vorausgehenden Anstrengungen unverhältnismäßige, durch Schlaf nicht aufzuhebende körperliche (insb. motorische), kognitive und/oder psychische Erschöpfung charakterisiert.“ (Vgl. ebd., S. 1106) Ein weiteres Merkmal ist das unabsehbare Auftreten der Erschöpfung, was wiederum den individuellen Energiehaushalt anbetrifft.

[4] Bei energetischer Verarmung, Fatigue und ähnlichen Krankheitsbildern wurde eher die Schonung der Betroffenen empfohlen.

[5] Die Beanspruchungsreaktionen können wiederum somatischer, kognitiver und auch emotionaler Natur sein. Ein Problem bei der Vermeidung der Crashs ist, dass es keine Verhältnismäßigkeit zwischen faktischer Belastung und der Auslösung der Zusammenbrüche gibt. Die technischen Möglichkeiten erlauben eine Belastungssteuerung in Echtzeit, was wiederum hilft, Zusammenbrüche zu vermeiden. (Vgl. ebd., S.1110)

[6] Ohne auf die Details der Auswertung hier weiter einzugehen, soll doch auf eine Problematik hingewiesen werden, an der wiederum die Herausforderungen therapeutischer Ansätze deutlich wird. So kam es bei Frauen zu einer Verschlechterung der sekundären psychosomatischen Symptome: Eine Erklärung hierfür ist der schnellere Verlauf der Therapie bei Männern und die sich daraus ergebende längere Beanspruchung bei Frauen, eine Selbstüberschätzung und ein ausweichendes Verhalten speziell junger Frauen. Therapien müssen diese Besonderheiten verstehen und reflexiv in ihren Behandlungen berücksichtigen, um die anderweitigen Erfolge nicht zu gefährden.