Mit der Sammlung von Daten, dem umgangssprachlichen Gold unseres Zeitalters, haben wir uns schon oft befasst. Die Unmenge an Datenmaterial, die infolge der Digitalisierung unter anderem der industriellen Produktion und Teilen der menschlichen Kommunikation zur Verfügung steht, eröffnet unserer Gegenwart völlig neue Wege und Tiefen der Analyse. Kurzum erlauben es die Expansivität moderner Sensorik und die Steigerung der Rechenleistung und Verarbeitungskapazitäten, große Mengen an Informationen aufzunehmen, zu ordnen und Erkenntnisse aus den gesammelten Daten zu gewinnen.

Mit dieser Entwicklung erlangt der spezifische Forschungsbereich der Data Analytics immer mehr an Bedeutung. Hierbei geht es um die Werkzeuge, die Technologien und Prozesse, mit deren Hilfe Muster, Verläufe und Problemlösungen gestützt auf ein Konvolut an Daten ermittelt werden können. Neben der eigentlichen analytischen Auswertung ist die Sicherung der Qualität der Datensätze und eine effiziente Archivverwaltung für die weiteren Schritte elementar.

Können elektrische Schafe halluzinieren?

Mit der Verbreitung KI-gestützter Technologien traten Phänomene in den Fokus der Öffentlichkeit, die der Data Analytics thematisch nahestehen: Infrage steht vereinfacht formuliert, ob zum Beispiel Chat GPT lügen kann. Bei manchen Anfragen kam es zu Ausgaben, die schlicht falsch waren, unter anderem ganz offensichtlicher Fehlurteile wie die Anzahl bestimmter Buchstaben in einem Wort. Dieses Phänomen wurde als Halluzination beschrieben und erhielt einige Aufmerksamkeit: Die Ermittlung der Ursache der Fehlausgabe hatte das Problem der Komplexität des Programms, aber nicht nur der Architektur der künstlichen Intelligenz mit seinen Legionen an Knotenpunkten und Schichten, sondern auch in Hinsicht der Datenmengen und deren komplexer Verwaltung. Letzterer Aspekt zielt auf die Archivstrukturen und den Umgang mit den riesigen Datenmengen und -banken, die großen Sprachmodellen wie Chat GPT für den Trainingsprozess zugrunde liegen.

Neben der Frage, warum diese Fehler überhaupt aufkamen, war auch offen, an welchen Zeitpunkt sie entstanden. Die Programme selbst waren selbstredend nicht zur Ausgabe falscher Antworten angehalten, gleichwohl verlangt der Umgang mit der natürlichen Sprache und manche Formen der Anwendung eine gewisse Qualität der Kreativität, also der Dehnung und Übertragung, die die Programme leisten müssen. Zum Beispiel bei dem Wunsch, den dritten Akt von Romeo und Julia in der Sprache modernen Ostküsten-HipHops zu reformulieren – ein solches Werk existiert bislang nicht, das Modell muss also selbst kreativ werden um diese Anfrage zu beantworten. Es werden große Anstrengungen unternommen, die Anzahl der Halluzinationen von Modellen zu minimieren, was auch die Relevanz zeigt, wie Daten verwertet und verarbeitet, Datensätze gereinigt oder auch korrumpierte Daten aussortiert oder gerettet werden. Und weiter, wie komplexe Technologien mit einem Gros an Datensätzen interagieren. Und hier setzt die Data Analytics an.

Was ist Data Analytics?

Die Data Analytics befasst sich mit der Analyse von Daten und deren Auswertung zu unterschiedlichen Zwecken. Sie ist ein multidisziplinäres Forschungsfeld zwischen der Informatik, der Mathematik und der Statistik sowie weiterer Bereiche, die produktiv verknüpft werden. Generell lässt sich die Data Analytics in vier Ansätze unterteilen: Die deskriptive Analyse versucht zu beschreiben, welche Veränderungen bereits geschehen sind. Dagegen zielt die diagnostische Analytik auf eine Erklärung, warum etwas wie passiert ist. Die letzten beiden Zugänge schlagen eine andere Richtung ein: Aus den Daten Prognosen über zukünftige Entwicklungen abzuleiten ist das Ziel der prädiktiven Analysen. Diese Prognose wird im Falle der präskriptiven Analytik noch durch die optimale Reaktion ergänzt. Die unterschiedlichen Ansätze verfolgen nicht nur verschiedene Ziele, sie gehen auch anders mit den Daten um und haben differenzierte Ansprüche an die Daten.

Seit gut zwei Jahren hat Constantin Pohl die Professur für „Data Analytics“ an der Fakultät für Informatik der Hochschule Schmalkalden inne und nutzt die Gelegenheit seiner Antrittsvorlesung, ein Licht auf verschiedene Facetten seiner Forschung und seiner Lehre zu werfen. Bereits in seiner Dissertation befasste er sich mit der Frage, wie sich moderne Hardware zur Beschleunigung von Datenbank-Anfragen optimal nutzen ließe. Anders formuliert war das Thema, wie Datenverwaltungen strukturiert und organisiert sein müssen, um Ressourcen und Kapazitäten bedarfsgerecht zu nutzen und Suchanfragen effizient zu verarbeiten. Die Datenmengen auf Servern nehmen einerseits beständig zu und macht Suchvorgänge aufwändiger und langsamer, zugleich erlauben die vielen Kerne moderner Prozessoren über das Multithreading parallele Verarbeitungen. So gilt es, Managementsystem für Datenbanken und Datenströme zu entwickeln, die den neuen Anforderungen gerecht werden und zudem die technischen Möglichkeiten optimal nutzen.

Öl-Druck und Reparaturzyklen

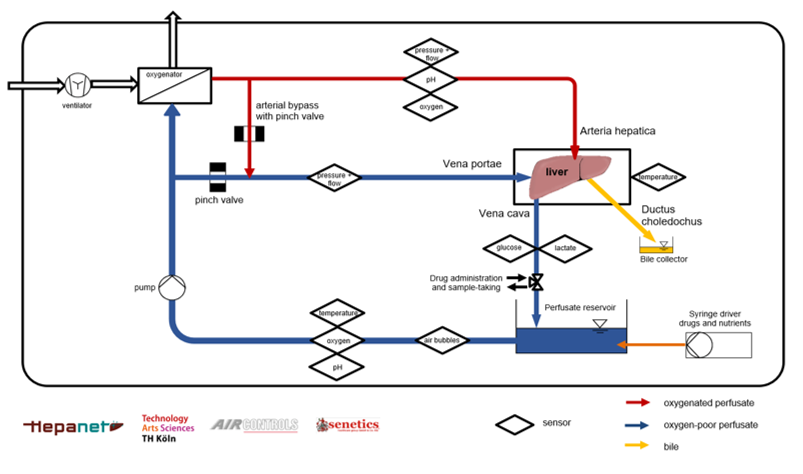

In einem zurückliegenden Forschungsprojekt widmete sich Constantin Pohl der Frage, wie KI-Modelle für die Wartung von industriellen Anlagen und Maschinen wie einem Druckluftkompressor genutzt werden können. Das Ziel ist, Wartungsarbeiten an Verschleißteilen nicht mehr an fixen Zeitpunkten oder nach Werkzeugausfällen anzusetzen, sondern vorausschauend anhand konkreter und in Echtzeit erhobener Daten der laufenden Maschinen. Um diese Optimierung zu realisieren ist eine Prognose wichtig: Anhand von Sensordaten sollen Aussagen über die Zukunft getroffen werden, zum Beispiel das ein Filter noch 22 Stunden halten wird, bevor er gewechselt werden sollte. Hieran ließen sich dann entsprechende Reparaturmaßnahmen orientieren.

Die Ausgangsbasis sind wieder verschiedene Sensoren, welche die Maschinen anhand unterschiedlicher Parameter vermessen. In dem konkreten Projekt wurden 26 Merkmale sensorisch erfasst, neben der Temperatur und der Ölqualität auch der Differenzdruck zwischen verschiedenen Filtern. Bevor mit diesen Daten aber Aussagen getroffen werden können, mussten die Algorithmen anhand der Ausfälle der Kompressoren trainiert werden. In Regressionsmodellen wurden unterschiedliche vorverarbeitete und ausgewählte Datenmengen genutzt, um Ausfälle vorherzusagen. Wichtig ist dabei zu verstehen, dass es hier nicht um eine Größe wie die Temperatur ging, um diese Prognose zu machen: Die Modelle berücksichtigen viele Daten und ihre Verläufe, auch über eine längere Zeit, und verknüpften diese zugleich. Diese komplexen Berechnungen sind die spezifischen Leistungen der KI-Modelle, die zur Erkennung von Mustern und Strukturen sowie Abweichungen geeignet sind.

Am Ende des Projektes ließ sich die Prognostizierbarkeit grundsätzlich umsetzen. Mit einem entwickelten Ölsensor und der Nutzung der regulären Sensorik konnten die fehlerhaften Vorhersagen auf 0,09% reduziert werden. Auch die maximalen Abweichungen waren bei einer Gesamtzahl 158.000 Vorhersagen nur in einem Fall bei sechs Tagen und ansonsten bei einem Tag. Der entscheidende Faktor für die erfolgreiche Ermittlung und Prognose ist der Ölsensor.

Datenströme

Neben dieser Thematik befasst sich Professor Pohl auch mit Fragen des Stream Processing: In der Datenverarbeitung lassen sich zwei Ansätze unterscheiden, die sich für verschiedene Anwendungen und Ziele eignen. Der klassische Weg ist die Paketlösung: In einem bestimmten Zeitraum werden Daten erfasst und dann als Block archiviert. Im Anschluss können diese Daten verarbeitet und ausgewertet werden. Offensichtlich ist hierbei die große Latenz, also die Zeitspanne, die zwischen der Messung und den Ergebnissen einer Auswertung steht. Das Stream Processing zielt dagegen auf die Auswertung der Datenströme in Echtzeit, wobei durch diesen Fokus andere Imperative der Verarbeitung wichtig werden.

Die Analyse von Datenströmen steht vor der Herausforderung, eine permanente Aufnahme und Verarbeitung zu gewährleisten. Die Auslastung muss so gestaltet werden, dass durch die Interaktion verschiedener Komponenten keine Flaschenhälse oder Stausituationen entstehen. Kurzum geht es darum, effiziente Strukturen zu etablieren, die eine möglichst permanente und effiziente Verteilung und Verarbeitung erlauben und die Kapazitäten entsprechend nutzen.

Constantin Pohl befasst sich mit der Entwicklung und Erprobung von Stream Processing Engines. Im konkreten Fall ging es um die Vorhersage des Zielhafens und der Ankunftszeit. Die pendelnden Schiffe geben während ihren Reisen permanent Informationen weiter, zum Beispiel über ihre Position, ihre Geschwindigkeit und den Schiffstyp, die in einem komplexen Modell für Vorsagen ihrer Zielhäfen genutzt werden können. Kurzum bietet sich so die Möglichkeit, über eine Einschätzung einer komplexen Sachlage mit vielen Akteuren und zu beachtenden Parametern Strategien der Optimierung der Zielhäfen zu entwickeln.

Fußstapfen

Constantin Pohl hat bislang noch eine Juniorprofessur an der Hochschule Schmalkalden, die im Rahmen des bundesweiten Projektes „FH-Personal“ geschaffen wurde. Mit seiner Berufung wurde die Professur von Martin Golz zu einer Schwerpunktprofessur, die es diesem erlaubt, das Lehrdeputat zu senken und sich vermehrt der Forschung zu widmen.

Professor Pohl kann seine Arbeit in einem laufenden Lehr- und Forschungsbetrieb aufnehmen und den Lehrstuhl intensiv kennenlernen. Ziel ist es, die Reibungsverluste zu minimieren und durch geteilte Wege strukturelle Kontinuitäten zu etablieren. Er unterrichtet neben Grundlagen der Daten- und Wissensverarbeitung auch Deep Learning Architekturen und Wissensentdeckung in Datenbanken. Als Mitglied im Prüfungsausschuss der Fakultät Informatik widmet er sich gemeinsam mit den anderen Mitgliedern den Problemen der Studierenden in Prüfungsangelegenheiten. Auch am Hochschulinformationstag und dem Absolvententreffen stellte er sich und seine Forschung dem interessierten Publikum vor.